Oggi la parola “presentazione” non significa più soltanto proiettare qualche slide su uno schermo. In un contesto aziendale sempre più competitivo e ibrido, la qualità con cui condividiamo contenuti fa la differenza tra un meeting produttivo e una perdita di tempo. È qui che entra in gioco il video HD per presentazioni professionali: non un semplice dettaglio tecnico, ma la base su cui costruire esperienze di comunicazione chiare, coinvolgenti e soprattutto affidabili.

Questa guida è pensata per chi vuole avere subito un quadro completo e pratico: quali strumenti servono, come si integrano tra loro e quali criteri considerare per non sbagliare un’installazione. L’obiettivo è mettere nelle mani di manager e system integrator tutte le informazioni necessarie per costruire oggi una sala riunioni, un’aula o uno spazio eventi in grado di garantire presentazioni fluide e di alto livello.

L’importanza del video HD nelle presentazioni professionali

Partiamo da un concetto fondamentale: un’immagine di qualità non è un vezzo estetico, ma una leva di efficacia. Quando un relatore mostra un grafico complesso, un video promozionale o una dashboard di dati, la definizione e la nitidezza del contenuto incidono direttamente sulla comprensione del messaggio.

L’alta risoluzione elimina ambiguità, riduce i fraintendimenti e amplifica la credibilità di chi parla.

Negli ultimi anni il passaggio dall’HD standard al Full HD e al 4K Ultra HD ha reso possibile una chiarezza visiva prima impensabile anche in contesti business. Oggi una soluzione professionale di video HD non si limita a “funzionare”, ma deve rispondere a criteri ben precisi: affidabilità nella trasmissione, compatibilità con diversi dispositivi, semplicità d’uso e sicurezza dei dati condivisi.

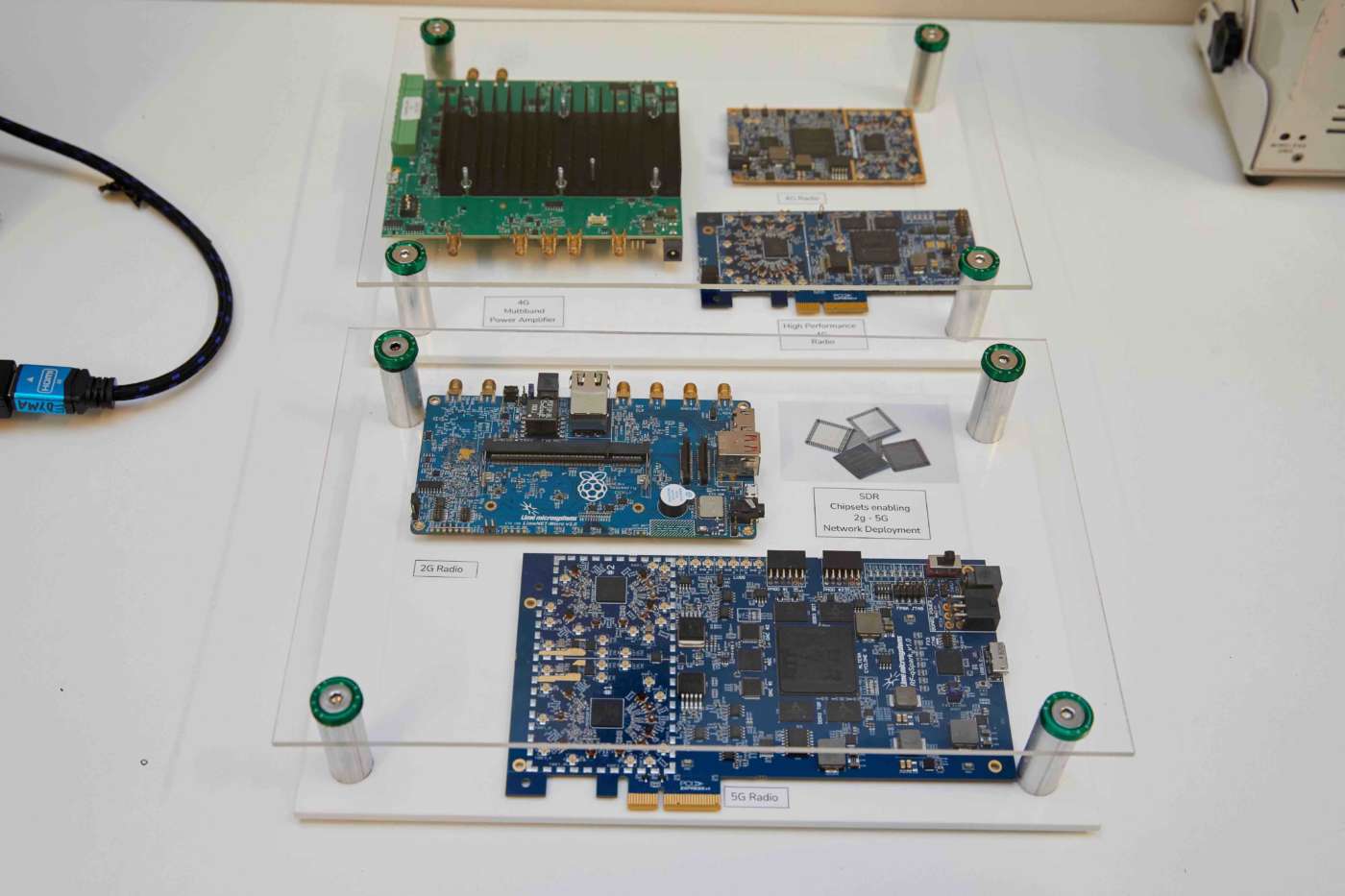

I pilastri di un sistema video HD professionale

Per realizzare un’installazione efficace non basta avere un display di grandi dimensioni. Un sistema di video HD professionale è fatto di più elementi che devono lavorare in sinergia: schermi ad alta definizione, strumenti di trasmissione cablata o wireless, telecamere dedicate alle riunioni ibride, accessori di controllo come telecomandi e puntatori, senza dimenticare il software di collaborazione. Ogni componente ha un ruolo preciso e il valore emerge dall’insieme, non dalla singola tecnologia.

Il punto di partenza è il display, che deve garantire luminosità, contrasto e definizione adeguati allo spazio in cui viene utilizzato. Una sala riunioni di medie dimensioni può richiedere un monitor da 75 pollici in 4K, mentre un auditorium avrà bisogno di proiettori professionali con ottiche intercambiabili.

Accanto al display si collocano i sistemi di trasmissione: cablati, se si privilegia la stabilità assoluta, o wireless, se si vuole flessibilità e rapidità di utilizzo.

Display e proiettori: scegliere lo schermo giusto

La scelta dello schermo è determinante per la resa complessiva. Oggi la tendenza è quella di preferire monitor professionali in 4K Ultra HD, che offrono immagini più definite anche a distanza ravvicinata. I proiettori restano fondamentali negli spazi ampi, soprattutto quando si devono coinvolgere decine o centinaia di persone.

La decisione tra monitor e proiettore dipende dal tipo di utilizzo: in un contesto aziendale con riunioni quotidiane può bastare un monitor di grandi dimensioni, mentre per eventi e centri congressi il proiettore offre maggiore scalabilità. In entrambi i casi, il criterio chiave resta la capacità di restituire il contenuto in alta definizione, senza latenza né distorsioni cromatiche.

Trasmissione del segnale: dal cablato al wireless 4K

Se fino a pochi anni fa i cavi HDMI erano l’unica garanzia di qualità, oggi i sistemi wireless hanno raggiunto livelli di affidabilità tali da poter sostituire le connessioni fisiche anche in contesti professionali. Dispositivi come lo Stream 4K Pro di Marmitek consentono di trasmettere contenuti in Ultra HD senza installazioni complesse e senza software aggiuntivo, offrendo un approccio plug & play estremamente apprezzato in azienda.

La possibilità di collegare più trasmettitori contemporaneamente rappresenta un vantaggio concreto nelle riunioni: il relatore può passare la parola a un collega con un semplice click, senza scambi di cavi o attese imbarazzanti. Inoltre, la funzione di schermo diviso permette di mostrare simultaneamente più contenuti, rendendo il confronto immediato e dinamico.

Le telecamere per videoconferenze: oltre la webcam

Con l’affermarsi delle riunioni ibride, la telecamera è diventata uno strumento imprescindibile in ogni installazione di video HD professionale. A differenza delle webcam integrate nei laptop, le conference cam offrono angoli di visione più ampi, risoluzioni elevate e microfoni integrati con cancellazione del rumore.

Un modello come la Cam 4K Pro di Marmitek è progettato per catturare con chiarezza tutti i partecipanti di una sala, garantendo un’immagine nitida e un audio cristallino. Questo si traduce in riunioni più professionali e coinvolgenti, dove la tecnologia lavora in silenzio al servizio della comunicazione.

Strumenti di controllo e interazione: telecomandi e puntatori

Non meno importanti degli schermi e delle telecamere sono gli strumenti che permettono al relatore di gestire la presentazione con naturalezza. Il telecomando per PC consente di muoversi liberamente nella sala, avanzare tra le slide, evidenziare concetti chiave e persino controllare contenuti multimediali.

Allo stesso modo, un puntatore laser avanzato offre funzioni aggiuntive come lo zoom o la modalità air mouse, trasformando l’interazione con il pubblico in un’esperienza dinamica.

Questi accessori possono sembrare marginali, ma in realtà contribuiscono a trasmettere professionalità e sicurezza. Un relatore che gestisce le slide senza esitazioni e mette in evidenza i dettagli giusti al momento giusto conquista attenzione e autorevolezza.

La configurazione di base di una sala riunioni

Mettere insieme tutti gli elementi significa definire una configurazione equilibrata. Una sala riunioni tipica dovrebbe includere: un monitor o proiettore 4K, un sistema di trasmissione wireless, una telecamera dedicata alle riunioni ibride e almeno un accessorio di controllo per il relatore. A questi si possono aggiungere microfoni ambientali o soundbar per migliorare la qualità audio, soprattutto in ambienti più ampi.

L’integrazione di questi strumenti deve essere curata per garantire un flusso di lavoro semplice. Il sistema deve accendersi in pochi secondi, collegarsi automaticamente e consentire a chiunque – manager, formatore o consulente esterno – di condividere contenuti senza dover chiedere aiuto all’IT.

Best practice per un’installazione efficace video HD

Chi progetta un sistema di video HD per presentazioni professionali deve considerare non solo la tecnologia, ma anche l’esperienza utente. È inutile avere un impianto sofisticato se i partecipanti impiegano dieci minuti a far partire la presentazione o se la connessione wireless cade a metà riunione.

Le regole fondamentali possono essere riassunte in pochi punti:

- Puntare su soluzioni plug & play compatibili con qualsiasi dispositivo (BYOD).

- Privilegiare sistemi che garantiscono sicurezza nella trasmissione, con connessioni criptate e pairing protetto.

- Effettuare sempre un test preventivo prima di meeting importanti, per evitare imprevisti.

Seguendo queste linee guida si crea un ambiente professionale in cui la tecnologia diventa trasparente e la comunicazione scorre senza intoppi.

Dal dettaglio tecnico al vantaggio competitivo

Un’installazione di video HD per presentazioni professionali non è solo una questione di hardware. È un investimento strategico che incide sulla produttività, sulla qualità delle decisioni e persino sull’immagine aziendale. Una sala riunioni ben progettata trasmette ordine, modernità e attenzione ai dettagli: elementi che i clienti e i partner percepiscono immediatamente.

Chi deve scegliere queste soluzioni – manager, responsabili IT o system integrator – ha oggi a disposizione strumenti maturi, affidabili e facili da utilizzare.

La sfida non è più tanto trovare la tecnologia giusta, ma integrarla in un ecosistema che funzioni per le persone. Perché, alla fine, la vera efficacia di un sistema video HD professionale si misura in questo: la capacità di rendere ogni presentazione chiara, coinvolgente e memorabile.

Esplora la gamma completa delle soluzioni Marmitek

Video HD per presentazioni professionali: strumenti avanzati e riunioni ibride

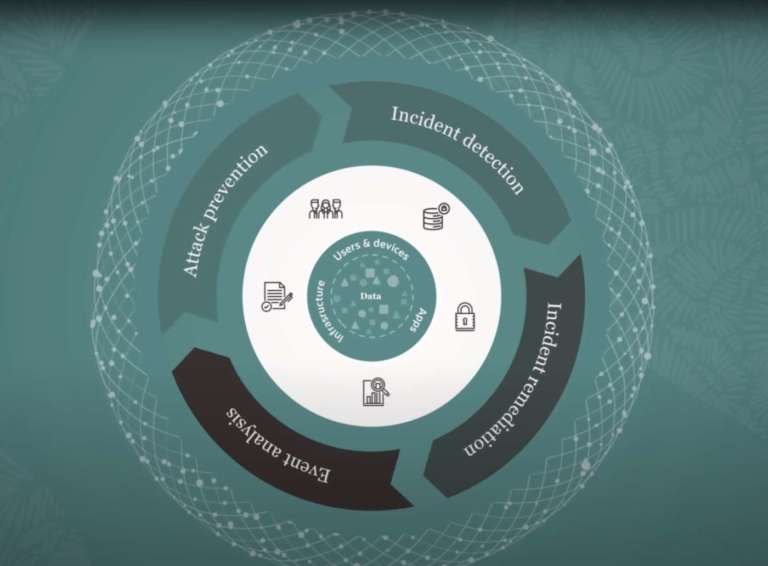

Se sinora abbiamo definito i pilastri di un’installazione di video HD professionale, è ora il momento di spingerci oltre e scoprire come la tecnologia possa arricchire l’esperienza delle presentazioni. Oggi, infatti, non basta proiettare un contenuto in alta definizione: il vero valore sta nella capacità di integrare più utenti, più dispositivi e, soprattutto, di connettere in modo fluido chi è in sala con chi partecipa da remoto.

Le riunioni ibride hanno reso indispensabile un ecosistema in cui presentazione e videoconferenza si intrecciano senza soluzione di continuità.

È qui che entrano in gioco strumenti avanzati come la condivisione simultanea di più schermi, la compatibilità BYOD, le telecamere intelligenti e le funzioni interattive che trasformano un meeting in un’esperienza realmente collaborativa.

Il ruolo del video HD nelle riunioni ibride

L’adozione di modelli di lavoro “phygital”, in cui parte del team si trova in sala e parte è collegata da remoto, ha reso evidente un fatto: senza un sistema video HD professionale, la qualità della collaborazione crolla. Un’immagine poco chiara o un audio disturbato compromettono la partecipazione e creano una frattura tra chi è presente e chi non lo è.

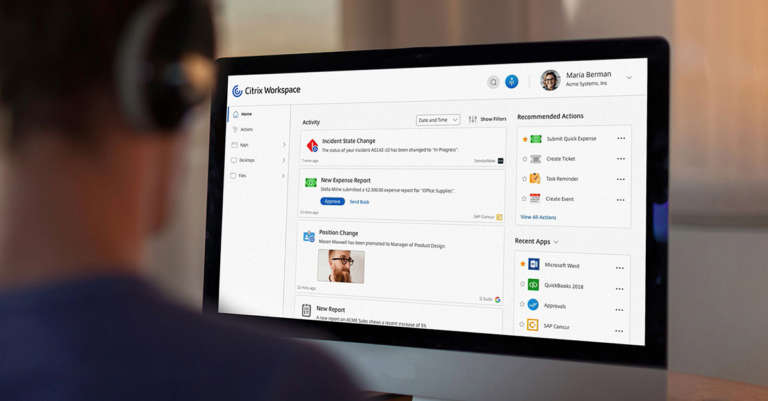

Ecco perché le soluzioni di presentazione wireless devono dialogare perfettamente con i software di videoconferenza.

Sistemi come lo Stream 4K Pro di Marmitek consentono di condividere contenuti in 4K Ultra HD e allo stesso tempo integrarsi con piattaforme come Teams o Zoom. In questo modo i presenti in sala vedono la presentazione in alta definizione, mentre i colleghi remoti la ricevono con la stessa qualità, senza interruzioni né compromessi.

Gestione multiutente e schermo diviso

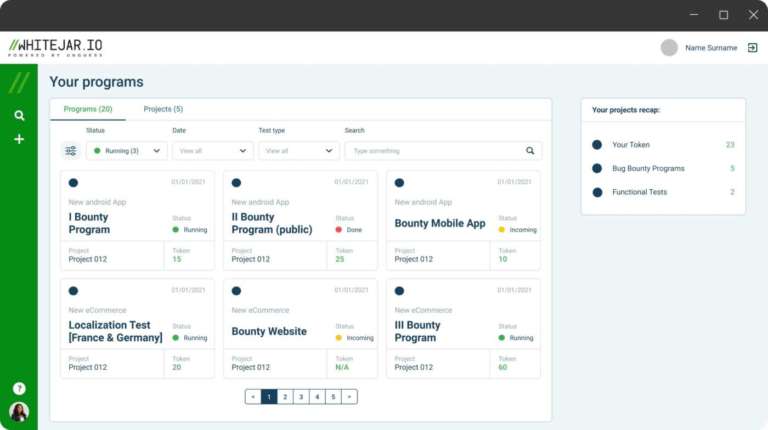

Una delle richieste più frequenti nei meeting aziendali è quella di poter confrontare più contenuti contemporaneamente. Con i sistemi tradizionali, questo significava interrompere la presentazione di un relatore per passare la connessione a un altro. Oggi invece la tecnologia consente di mostrare fino a quattro schermi in parallelo, sfruttando la funzione di schermo diviso.

Il risultato è un flusso di lavoro più naturale: due team possono esporre i propri dati, confrontare slide e discutere in tempo reale senza interruzioni. Allo stesso modo, più relatori possono alternarsi rapidamente con la semplice pressione di un pulsante, evitando tempi morti. È una funzionalità che aumenta l’efficienza e valorizza il contributo di ciascun partecipante.

Soluzioni all-in-one e compatibilità BYOD

La flessibilità è una parola chiave quando si parla di video HD per presentazioni professionali. Le aziende non possono permettersi soluzioni che funzionano solo con un sistema operativo o che richiedono configurazioni complicate. Ecco perché i dispositivi plug & play, compatibili con Windows, macOS, Android e iOS, stanno diventando lo standard.

Il principio BYOD (Bring Your Own Device) non è più un’opzione, ma una necessità. Ogni partecipante deve poter collegare il proprio laptop, tablet o smartphone senza difficoltà. Soluzioni come lo Stream 4K Pro rispondono perfettamente a questa esigenza, garantendo compatibilità universale e passaggi fluidi da un relatore all’altro.

Telecamere intelligenti e intelligenza artificiale

Se la prima evoluzione delle telecamere per videoconferenza è stata l’alta definizione, la seconda è senza dubbio l’intelligenza artificiale. Modelli come la Cam 4K Pro integrano funzioni di auto-framing, che riconoscono chi sta parlando e lo inquadrano automaticamente. Allo stesso modo, la cancellazione del rumore e il bilanciamento automatico della luminosità rendono l’immagine e l’audio sempre ottimali, indipendentemente dalle condizioni della sala.

Queste tecnologie non sono un semplice gadget, ma un reale potenziamento della user experience. Significa eliminare distrazioni, ridurre la fatica visiva e mantenere alta l’attenzione dei partecipanti, sia in sala che da remoto.

Accessori per interattività e collaborazione

Un’installazione di video HD professionale non si limita a trasmettere immagini e suoni: deve anche facilitare l’interazione. Oggi è possibile integrare lavagne digitali per prendere appunti in tempo reale, funzioni touchback per controllare il laptop direttamente dallo schermo, oppure collegare microfoni ambientali che catturano ogni voce con chiarezza.

Questi strumenti trasformano la riunione in un momento partecipativo. Non c’è più un relatore che parla e un pubblico che ascolta: c’è un gruppo che collabora, annota, commenta e costruisce insieme, sfruttando la tecnologia per potenziare il lavoro di squadra.

Un esempio di setup per una sala conferenze ibrida

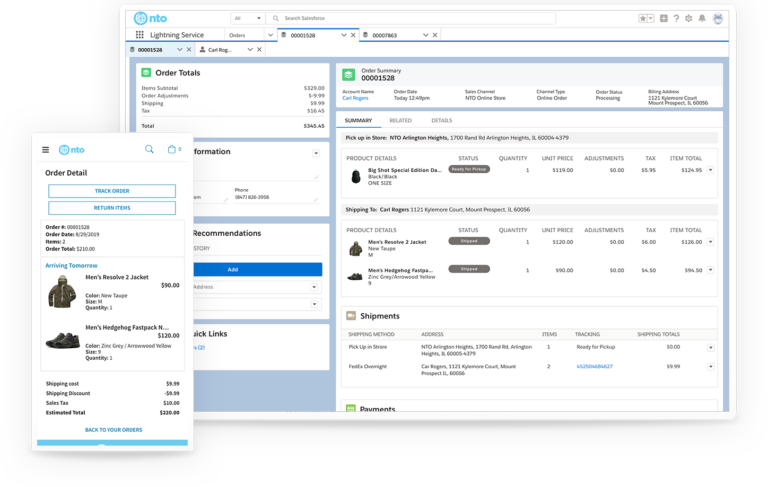

Per capire come questi strumenti possano convivere, immaginiamo una tipica sala conferenze aziendale. Al centro troviamo un display 4K di grandi dimensioni, collegato a un sistema di trasmissione wireless come lo Stream 4K Pro. Accanto al display, una conference cam 4K con microfoni integrati assicura che tutti i presenti siano ben visibili e udibili.

I partecipanti entrano in sala con i propri dispositivi, si collegano con un click e possono condividere contenuti in pochi secondi. Se più persone devono presentare, lo fanno contemporaneamente grazie allo schermo diviso.

Nel frattempo, i colleghi da remoto vedono la stessa qualità attraverso Teams o Zoom, senza perdere nulla della discussione. Una lavagna interattiva completa l’allestimento, permettendo di annotare idee e di condividerle all’istante con tutti i partecipanti.

Dall’integrazione all’esperienza

La vera evoluzione del video HD per presentazioni professionali non è solo nella risoluzione, ma nella capacità di integrare persone, dispositivi e spazi in un’esperienza unica. L’alta definizione è il punto di partenza, ma ciò che rende oggi una riunione davvero efficace è la possibilità di collaborare senza barriere.

Per i manager significa avere strumenti che semplificano e potenziano la comunicazione. Per i system integrator, invece, è la sfida di progettare ambienti dove ogni tecnologia è al servizio della collaborazione. Un obiettivo che si raggiunge solo scegliendo soluzioni affidabili, scalabili e facili da usare: perché la vera innovazione è quella che rende le cose più semplici, non più complesse.

Esplora la gamma completa delle soluzioni Marmitek