Per iniziare, facciamo il punto sulle date. Il rilascio in ftp della prima versione di ciò che chiamiamo Linux, la 0.01, è del 17 settembre 1991, come racconta Linus Torvalds nel suo Rivoluzionario per caso (Garzanti 2001).

L’inizio del lavoro era stato in aprile, ma il primo annuncio pubblico si data quattro mesi più tardi. In effetti, giovedì 25 agosto 2016 sono scoccati venticinque anni dal momento in cui Linus Torvalds annunciò pubblicamente il suo nuovo hobby, per arrivare meno di un mese dopo, per l’appunto il 17 settembre, al primo rilascio.

Arrivati al giorno d’oggi quel sistema operativo, battezzato Linux da uno dei colleghi di Linus, è stato portato su una varietà di piattaforme hardware superiore a quella di qualsiasi altro OS. Ma come, e perché, Linux si è trasformato da “semplicemente un hobby” al sistema operativo in più forte crescita su scala globale? Ripercorriamo un po’ di storia.

Arrivati al giorno d’oggi quel sistema operativo, battezzato Linux da uno dei colleghi di Linus, è stato portato su una varietà di piattaforme hardware superiore a quella di qualsiasi altro OS. Ma come, e perché, Linux si è trasformato da “semplicemente un hobby” al sistema operativo in più forte crescita su scala globale? Ripercorriamo un po’ di storia.

La nascita di Freax

Negli anni Ottanta e nei primi anni Novanta, Unix era il sistema operativo che veniva usato da molti studenti d’informatica. All’epoca la cosa non rappresentava un particolare problema: d’altra parte si trattava di un OS robusto contraddistinto da funzioni che andavano ben oltre quel che poteva offrire Windows, come ad esempio il multitasking. Tuttavia Unix non era libero, né gratuito, né adatto ad home o personal computer dell’epoca, quindi gli studenti non potevano usarlo a casa. Esisteva sì un’alternativa accessibile come Minix, ma era un sistema su piccola scala creato da Andrew Tanenbaum principalmente per aiutare i docenti a insegnare l’informatica.

Minix funzionava anche su un sistema Atari, mentre altre versioni di Unix giravano anche su 80286. Ma quando Intel fece uscire il processore 80386, gli studenti ebbero la possibilità di dotarsi di personal computer capaci di far girare una variante di Unix.

Linus era cosciente della vastità di Unix System V e delle limitazioni di Minix, sulle quali ebbe anche uno scambio di idee con Tanenbaum (inizio 1992). Per questo decise di creare un proprio OS libero affinché gli studenti potessero lavorare sui PC di casa. Il primo nome fu diverso da quello che conosciamo: Freax! Successivamente si scelse un altro nome, quello al quale è legata la sua fama.

Un primo interesse

Fin dagli inizi, il nuovo sistema operativo suscitò interesse in rete. Non essendovi impegnato alcun team di grandi dimensioni né un project manager, Linus prese la brillante decisione di rendere il sistema liberamente disponibile da subito. Così facendo poté coinvolgere programmatori di tutto il mondo. Motivati solamente dalla volontà di progettare un ottimo sistema operativo – e successivamente una ricca distribuzione – studenti e appassionati presero parte all’iniziativa e iniziarono ad aggiungere funzionalità e rimuovere bug. Si parlava inizialmente del solo kernel, a lungo gestito interamente dal solo Linus.

Torvalds è da sempre concentrato sulla realizzazione di un kernel Linux di altissima qualità, pertanto accetta solamente codice sorgente che aiuti Linux ad andare verso questa direzione.

Linux entra nel mondo enterprise

Questa, in sintesi, è la nota rilasciata in queste ore da Ralf Flaxa, president of engineering di SUSE su questo anniversario.

Questa, in sintesi, è la nota rilasciata in queste ore da Ralf Flaxa, president of engineering di SUSE su questo anniversario.

Alla sua nota possiamo aggiungere che Linux è nato per portare Unix sul desktop, quindi in direzione diversa dall’Ict aziendale. A quell’epoca era impensabile che un singolo programmatore, “inesperto” secondo quei criteri (ma quanti si erano riscritti i driver del Sinclair QL?), potesse riscrivere Unix a mano, ripulendo lo dagli appesantimenti dati dalle varie versioni succedutesi fino ad allora, e farne un kernel migliore di quelli esistenti. Dopotutto, un programmatore da dieci linee di Cobol al giorno poteva costare fino ad un milione di lire, in quei giorni. Dopo un intero decennio di lotte tra opsys (chi ricorda Osf e Motif?), ben presto, ricorda Ralf, l’interesse delle aziende per Linux s’impennò: incredibilmente era possibile ottenere Unix praticamente a costo zero! Certo, Linux non era sufficientemente robusto: occorreva arricchirlo con un’enorme quantità di lavoro, sia volontario, sia orientato.

Il principale elemento catalizzatore del cambiamento fu la disponibilità di Linux anche per piattaforme hardware diverse dal PC, come ad esempio Dec Alpha. Quando questo accadde, Linux divenne un prodotto di livello commerciale e le aziende poterono iniziare a usare questa nuova tecnologia come alternativa realistica a Unix o Windows.

La trasformazione digitale

Si capì che Linux ce l’aveva fatta nel momento in cui i primi grandi produttori hardware decisero di supportarlo. Un buon esempio di questo sul lato hardware è stata la decisione di Ibm di investire un miliardo di dollari a favore della tecnologia. Un altro paio di esempi importanti riguardano le applicazioni: Oracle fece il porting del database, poi seguita da Sap. Una stella era nata.

Oggi lo stesso cloud computing è spesso abilitato da un cuore Linux, ormai pronto a qualsiasi applicazione mission critical. La sua espansione continua: il cuore di Freax si ritrova ovunque le aziende siano solite implementare applicazioni Internet, od ovunque vengano memorizzati dati. I vantaggi sono chiari: l’ininterrotto interesse verso Linux da parte di una sempre crescente community degli sviluppatori significa che i gap di sicurezza vengono chiusi rapidamente e che gli aggiornamenti avvengono più velocemente rispetto a quanto accade con i produttori di software proprietario. E l’espansione sta continuando nientemeno che nel mondo supercomputing.

Linux in tasca

Possiamo dire che Linux è diventato il sistema operativo per eccellenza negli ambienti enterprise. Il sogno di andare sul tavolo non si è materializzato, certo, ma c’è di meglio. Il PC, per essere davvero personale, non sta né sul tavolo né sulle ginocchia, bensì in tasca. È lo smartphone a realizzare le promesse del personal computer, anche limitando l’esagerata capacità di produrre o editare contenuti, a favore della loro riproducibilità.

E Flaxa lo conferma. La maggior parte delle persone interagisce con Linux quotidianamente a livello consumer, anche se spesso non se ne rende conto. Usate uno smartphone Android? In questo caso state utilizzando Linux su base quotidiana. Android adotta il kernel Linux ed è mantenuto da Google. E Linux viene usato anche da una ampia varietà di altri dispositivi smart basati su Android.

Ovviamente è ancora adatto a tutte le applicazioni di connected something (dalla Tv all’auto) e dell’internet delle cose.

Buon compleanno, Linux! Cento di questi giorni al software e – aggiungiamo noi – mille al suo creatore, che più volte incontrammo, in quegli anni, in Italia e in California.

In chiusura, ecco l’infografica realizzata da Suse per ricordare tutto il percorso di questi 25 anni.

A circa un anno dal suo insediamento, Samaritani porta al Forum i primi risultati. Alcuni progetti sono partiti, ma bisogna passare dall’artigianato all’industria, accelerando l’adozione di svariate piattaforme, tra le quali i pagamenti ma soprattutto

A circa un anno dal suo insediamento, Samaritani porta al Forum i primi risultati. Alcuni progetti sono partiti, ma bisogna passare dall’artigianato all’industria, accelerando l’adozione di svariate piattaforme, tra le quali i pagamenti ma soprattutto Più ampio della sola digitalizzazione, l’attuale processo di modernizzazione è spesso presentato come una forma di risparmio immediato. “Razionalizzare la spesa è una cosa, ridurla è un’altra”, ha detto Guido Scorza, avvocato presente al Forum Pa in veste di Presidente dell’Istituto per l’Innovazione. Il punto centrale di Scorza è però un altro: la democrazia prevede la tutela di tutti, che non si ottiene digitalizzando senza criterio. “Esistono situazioni diversamente digitali”, ha proseguito Scorza, “ma quel che serve è che le tutele democratiche siano interne al software di piattaforme ed ecosistemi”.

Più ampio della sola digitalizzazione, l’attuale processo di modernizzazione è spesso presentato come una forma di risparmio immediato. “Razionalizzare la spesa è una cosa, ridurla è un’altra”, ha detto Guido Scorza, avvocato presente al Forum Pa in veste di Presidente dell’Istituto per l’Innovazione. Il punto centrale di Scorza è però un altro: la democrazia prevede la tutela di tutti, che non si ottiene digitalizzando senza criterio. “Esistono situazioni diversamente digitali”, ha proseguito Scorza, “ma quel che serve è che le tutele democratiche siano interne al software di piattaforme ed ecosistemi”.

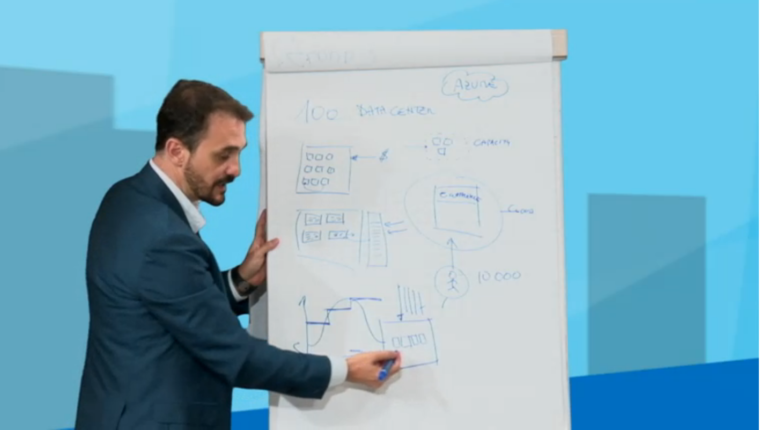

“Per diventare gestori Spid abbiamo investito circa 1 milione di euro, che avremmo potuto destinare altrove”, ad esempio al nuovo datacenter di Ponte S. Pietro, “non abbiamo fatto le corse e non siamo stati tra i primi tre certificatori, ma crediamo in Spid e ci siamo impegnati molto anche a livello pubblicitario”. A parlare è Simone Braccagni, Ad di

“Per diventare gestori Spid abbiamo investito circa 1 milione di euro, che avremmo potuto destinare altrove”, ad esempio al nuovo datacenter di Ponte S. Pietro, “non abbiamo fatto le corse e non siamo stati tra i primi tre certificatori, ma crediamo in Spid e ci siamo impegnati molto anche a livello pubblicitario”. A parlare è Simone Braccagni, Ad di  Un vantaggio forte di Aruba è lo sviluppo del software in house, che per il cliente è sempre positivo. Sempre con questa filosofia l’azienda ha appena lanciato

Un vantaggio forte di Aruba è lo sviluppo del software in house, che per il cliente è sempre positivo. Sempre con questa filosofia l’azienda ha appena lanciato

trovare un accordo sul valore complessivo dei fondi raccolti fino ad oggi e quanti progetti abbiano effettivamente beneficiato di questo straordinario strumento”, scrive

trovare un accordo sul valore complessivo dei fondi raccolti fino ad oggi e quanti progetti abbiano effettivamente beneficiato di questo straordinario strumento”, scrive

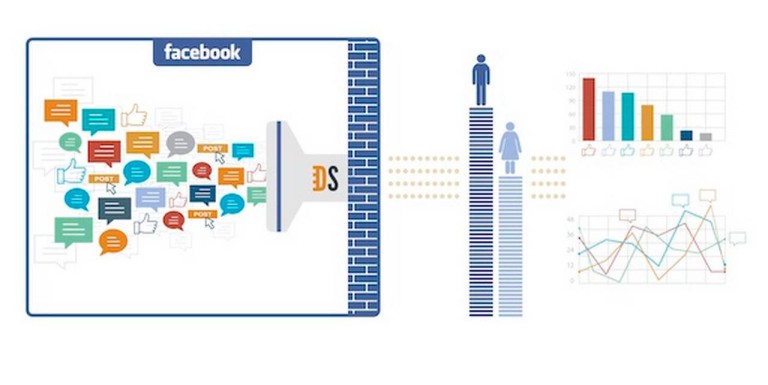

“Con Facebook topic data si colma uno dei principali gap del mondo della social media intelligence su Facebook”, ha detto Sacha Monotti Graziadei, Ceo di Blogmeter. “Nel 2015, l’azienda ha supportato più di 130 aziende e agenzie realizzando oltre 160 progetti di ricerca”.

“Con Facebook topic data si colma uno dei principali gap del mondo della social media intelligence su Facebook”, ha detto Sacha Monotti Graziadei, Ceo di Blogmeter. “Nel 2015, l’azienda ha supportato più di 130 aziende e agenzie realizzando oltre 160 progetti di ricerca”.

Di tutti questi temi abbiamo parlato con Tommaso Solfrini, Sales Manager di

Di tutti questi temi abbiamo parlato con Tommaso Solfrini, Sales Manager di

Anche la parte tecnica è di grandissimo impatto sulla comunità degli sviluppatori. “Adesso è disponibile l’emulatore anche per iOs”, ha detto Miguel de Icaza, co-founder di Xamarin, “il che porta al risparmio secco di una sedia che ruota tra schermi”. Le funzionalità sono entusiasmanti: è possibile visualizzare le modifiche al codice in tempo reale sugli emulatori iOs, Android e Windows, direttamente e senza dover studiare centinaia di nuove Api.

Anche la parte tecnica è di grandissimo impatto sulla comunità degli sviluppatori. “Adesso è disponibile l’emulatore anche per iOs”, ha detto Miguel de Icaza, co-founder di Xamarin, “il che porta al risparmio secco di una sedia che ruota tra schermi”. Le funzionalità sono entusiasmanti: è possibile visualizzare le modifiche al codice in tempo reale sugli emulatori iOs, Android e Windows, direttamente e senza dover studiare centinaia di nuove Api.