ll multicloud è passato da esperimento provvisorio a componente fondamentale nello sviluppo delle strategie It. Dagli sviluppatori ai team di sicurezza, i carichi di lavoro migrano sempre più verso il cloud, qualunque sia la forma scelta.

“In particolare – spiega Tristan Liverpool, Systems Engineering Director di F5 Networks – l’adozione del cloud ha alimentato un cambiamento profondo nel modo in cui le organizzazioni approcciano lo sviluppo e la delivery delle app. Una trasformazione che appare evidente, per esempio, se pensiamo ai modelli cloud basati su SaaS, che offrono alle aziende la libertà di scegliere esattamente dove distribuire le operazioni cloud riducendo al contempo i costi”.

Avere a che fare con un contesto multi-cloud ha chiaramente stimolato nuove modalità di fare business, più agili e olistiche, legate, per esempio, all’adozione sempre più diffusa di pratiche DevOps, NetOps e SecOps. “In questo modo – prosegue Liverpool – lo sviluppo delle applicazioni è migrato sempre più dalle infrastrutture locali alle infrastrutture cloud, comportando per le aziende la necessità di ripensare a come le diverse funzioni aziendali siano coinvolte e si relazionino con i nuovi approcci allo sviluppo del software. I team aziendali hanno tutti requisiti e modalità di lavoro differenti, quindi è basilare trovare un equilibrio che offra risultati su tutta la linea senza sollevare attriti o dover ricorrere a compromessi”.

Il cloud, ovvero la delizia dei DevOps

La cultura DevOps è incentrata sulla velocità e sull’innovazione continua. Il cloud consente a sviluppatori e DevOps di raggiungere esattamente questo obiettivo fornendo una piattaforma standardizzata, efficiente e ideale per test, implementazione e produzione. “Consente – aggiunge Liverpool – un processo di sviluppo più fluido che corrisponde al ritmo con cui i DevOps possono avviare le applicazioni, senza sacrificare stabilità, scalabilità e sicurezza. C’è sempre spazio per eventuali cambiamenti rapidi dell’ultimo minuto relativi alla integrazione e alla delivery continuative.

I team DevOps, quindi, possono considerare il cloud come una nuova norma ed estensione della propria infrastruttura di rete. Ciò significa abbracciare completamente gli ambienti di cloud pubblico nativi, per gestire le prestazioni delle applicazioni all’interno del cloud, nonché sfruttare i modelli SaaS per il contenimento dei costi e per supportare la scalabilità dell’innovazione.

Il cloud come risposta per i NetOps

“Anche il ruolo dei NetOps sta cambiando – sostiene Liverpool – non abbiamo più a che fare con team che gestiscono e monitorano risorse hardware e software. Ora abbiamo persone focalizzate sulla costruzione di un ecosistema di rete multi-componente, capace di supportare un’ampia varietà di obiettivi aziendali.

Man mano che cresce la quantità di carichi di lavoro spostati sul cloud, cresceranno le richieste ai team NetOps affinché si adattino rapidamente e passino dall’adozione di strumenti manuali e processi più lenti a sistemi più efficienti, compatibili con modelli DevOps agili”.

“Ai NetOps è inoltre richiesto di raggiungere – afferma Liverpool – la parità dal punto di vista dell’automazione rispetto ai team che si occupano dello sviluppo delle app. Se non riescono a tenere il passo con continui aggiornamenti dell’applicazione, infatti, diventeranno presto il collo di bottiglia nello sviluppo delle applicazioni”.

Per Liverpool fortunatamente, il problema è stato risolto proprio grazie ai servizi cloud SaaS che rendono oggi possibile ai NetOps gi affrontare aree specifiche del business, nelle quali le reti legacy limitano l’innovazione, e indirizzare successivamente infrastrutture digitali più fluide per collaborare meglio con altri team.

Il cloud come estensione della security

Da sempre le operation adottano Kpi predefiniti in termini di livello della sicurezza e di servizio, il che può spiegare perché il loro approccio all’adozione della tecnologia sia generalmente più conservativo.

“Se si desse loro la scelta – precisa Leverpol – i team di sicurezza opererebbero con reti zero-trust – e giustamente, dal loro punto di vista”.

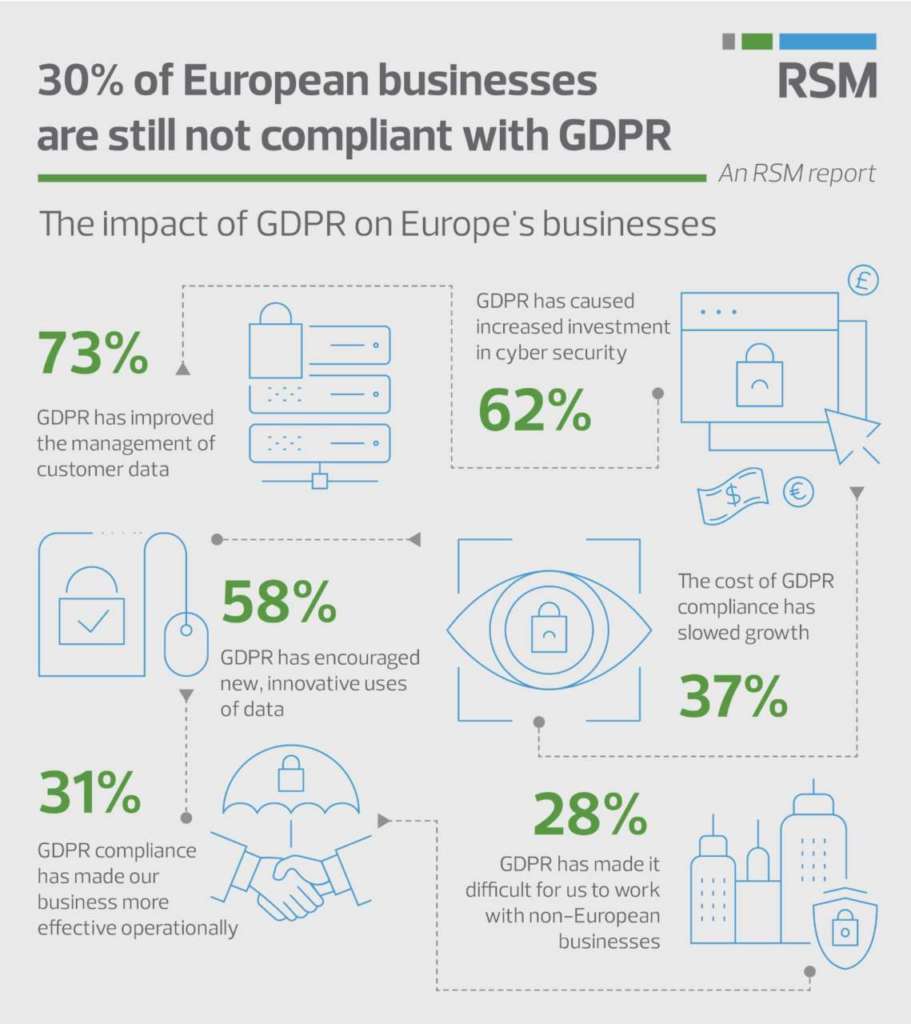

In effetti, come ha rivelato una recente ricerca di F5 incentrata sui comportamenti di DevOps e NetOps, la sicurezza nel cloud è spesso un “ripensamento” per la maggior parte degli sviluppatori, in quanto assegnano la priorità alla velocità rispetto alle problematiche di sicurezza e affidabilità.

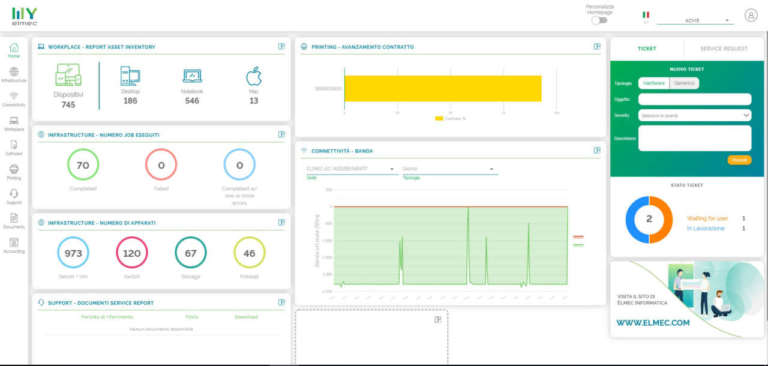

“È importante comprendere – sostiene Liverpool – che i servizi cloud possono rappresentare un prolungamento per i team di sicurezza, fornendo loro le informazioni e gli strumenti necessari per tenere il passo con un panorama delle minacce in costante evoluzione. Tali servizi sono anche in grado di garantire la giusta governance in modo da monitorare e bilanciare le esigenze di innovazione e controllo (per esempio tramite dashboard e report)”.

“Nella nuova era definita dal software – aggiunge Liverpool – l’adozione del cloud è decisamente una leva positiva per lo sviluppo di applicazioni critiche per il business. Questo perché il mercato non solo richiede processi di produzione maggiormente efficaci, ma perché il nostro mondo, incentrato sulle applicazioni, richiede velocità e affidabilità nel servizio”.

“Bisogna ricordare sempre – conclude Liverpool – che tutti i team aziendali alla fine operano con il medesimo scopo: supportare una delivery continuativa di applicazioni di qualità. La collaborazione e le partnership sono più facili da sostenere quando tutte le parti condividono la medesima piattaforma che distribuisce le app e hanno accesso all’analitiche sottostanti per affinare e ridefinire gli obiettivi. Il giusto approccio multi-cloud e il suo supporto devono quindi essere inclusivi, cioè considerare in modo equo i team che si occupano dell’infrastruttura, gli sviluppatori e gli utenti aziendali. Le barriere culturali all’adozione del multi-cloud stanno scomparendo ed è essenziale collaborare nel cloud per non rischiare di rimanere indietro rispetto alla curva dell’innovazione, essendo sicuri di comprenderne tutte le implicazioni e coglierne le opportunità”.